● GPT1(2018)

OpenAI는 2015년 인간 전체에 이익이 되는 범용 인공지능 개발을 목표로 만들어진 연구소입니다.

(2019년 마이크로소프트의 1조 투자를 받는 등 영리 색이 더해지면서 설립자 중 하나인 앨런 머스크가 반발하기도 하였습니다.)

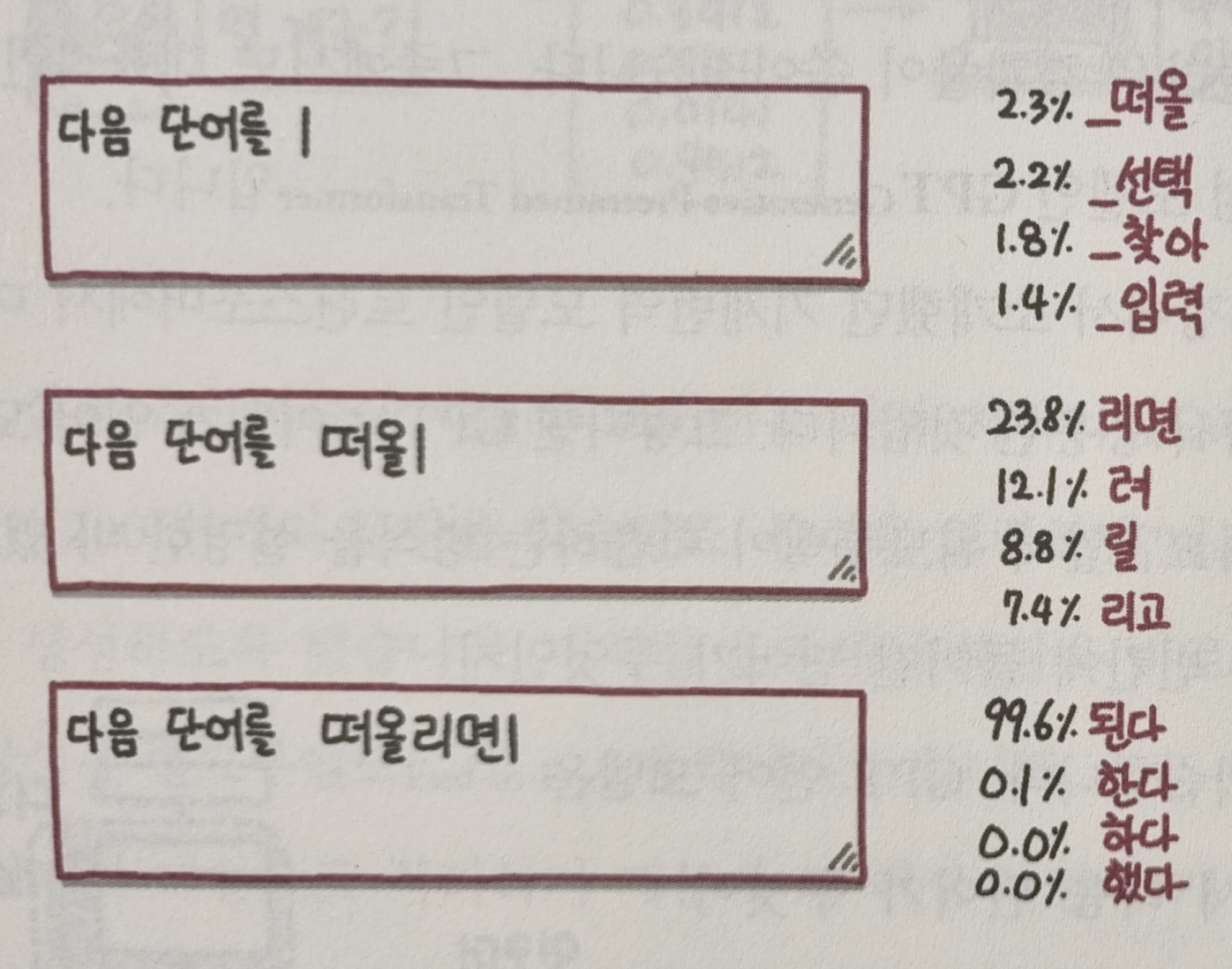

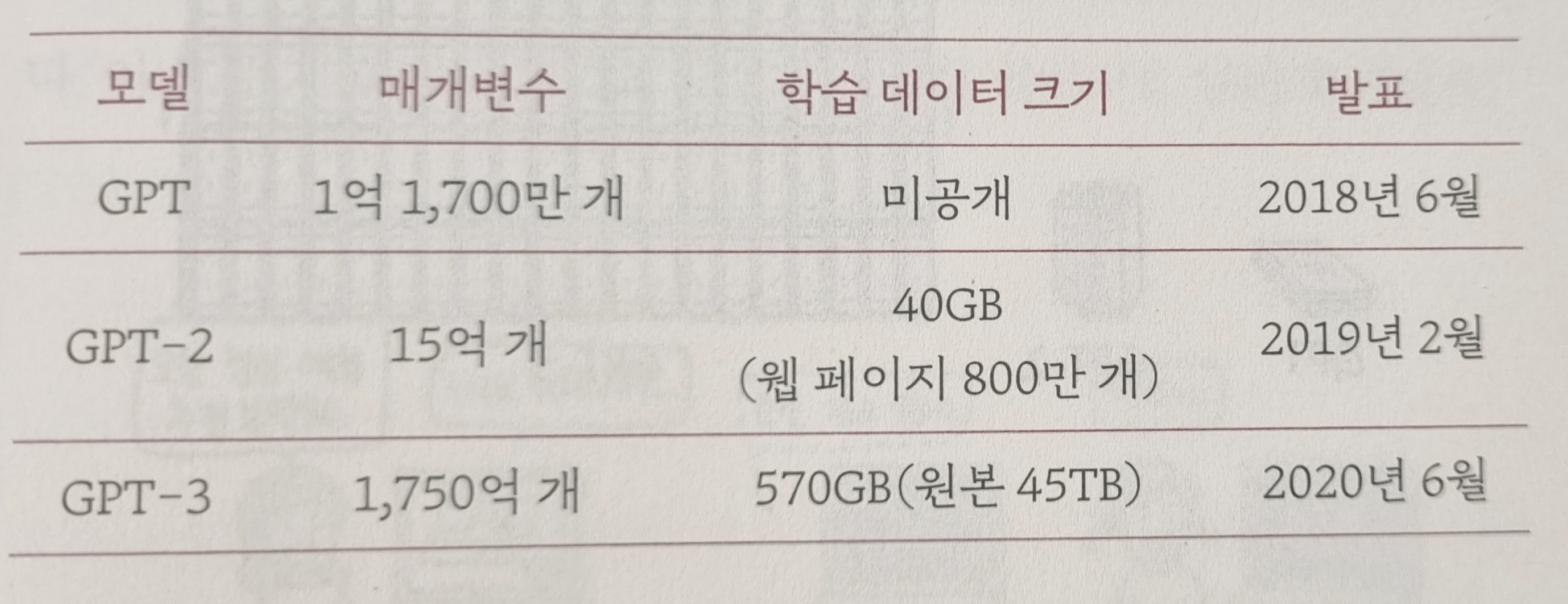

여기서 만든 GPT(2018년 GPT1)는 다음 단어를 맞추어서 문장을 생성할 수 있습니다. 아직까진 성능은 평범했습니다.

● GPT2(2019)가 나오면서 성능이 어마어마해집니다.

- GPT2의 매개변수(parameter)는 15억개였는데, 모델의 변화를 조절할 수 있는 스위치가 15억개나 달려있는 셈.

- 이 때부터 사람이 직접 글을 쓴 것처럼 성능이 너무 좋아서 스팸, 가짜뉴스 등을 쏟아낼 우려가 있어서 위험할 정도가 됨.

● GPT3(2020)는 더욱 더 강력해짐. 45TB의 데이터를 학습하는데 120억의 비용이 들었다고 함.

- 웹 사이트 코딩, 파워포인트 만들기, 영어-프랑스 번역 등.

- 인류가 그동안 축적한 수많은 문장 대부분을 암기했을 뿐 아니라, 인터넷에 있는 방대한 데이터를 거의 모조리 학습했음.

- OpenAI는 GPT-3를 유료 API로 제공(2020년 11월)하기로 결정했고, 소스코드에 접근 권한은 마이크로소프트에 독점 부여함.

● 하이퍼클로바 : 네이버에서 만든 한국어 버전 GPT

- 매개변수가 GPT-3보다 훨씬 많은 2000억 개.

'책 리뷰 > 비전공자를 위한 ai 지식' 카테고리의 다른 글

| [추천시스템 9-2] 연관성 분석 - 장바구니 분석(맥주,기저귀는 함께 팔린다) (0) | 2022.06.20 |

|---|---|

| [추천시스템 9-1] 다양한 기업들의 추천시스템 (0) | 2022.06.20 |

| [챗봇 7-5] 이루다의 대화 원리 - BERT, QA, 코사인 유사도 (0) | 2022.06.19 |

| [챗봇 7-4] 질의 응답(QA)에 특화된 모델 - BERT (0) | 2022.06.19 |

| [챗봇 7-1] 이루다는 왜 2주만에 서비스를 멈췄을까? (0) | 2022.06.19 |