책 리뷰/비전공자를 위한 ai 지식

[챗봇 7-4] 질의 응답(QA)에 특화된 모델 - BERT

Aiden_

2022. 6. 19. 21:05

BERT는 트랜스포머의 인코더 부분을 활용함. 인코더는 문장을 이해하는 부분 - 따라서 BERT는 문장 이해에 특화된 모델임.

● bert의 학습 방법 : 문장 내 15%의 단어를 무작위로 가리고 그 단어를 맞추도록 학습함.

(앞서 2013년 나온 워드투벡은 문장의 가운데 빈칸을 순차적으로 뚫어가면서 맞춤)

● BERT의 학습 원리 : 전이 학습(transfer learning)

예시 : "백두산의 높이는 얼마야?" 지리책을 많이 읽는 친구는 쉽게 대답할 것.

한라산이 1,950m라는 것을 알고 있었다면, 그리고 백두산이 한반도에서 가장 높은 산이라는 것을 알았다면,

백두산이 일단은 2,000m가 넘는다고 유추할 수 있을 것입니다.

이처럼 사전 지식을 활용하여 학습하는 것을 전이 학습(transfer learning)이라고 말합니다.

사전 지식을 그대로 활용하면서 문제해결을 위한 약간의 추가 학습을 하면 됩니다. 이것을 fine-tunning한다고 말하기도 합니다.

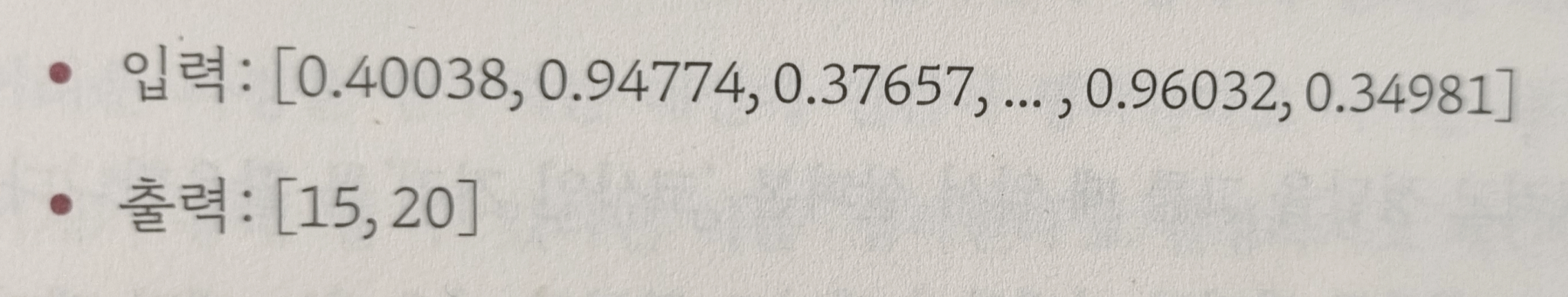

bert는 사전 학습한 문장 중 15번째 글자부터 20번째 글자(2,750m)를 99%의 확률로 정답으로 예측합니다.

즉, 본문(context)에서 정답의 위치를 확률적으로 계산합니다.